Mochi 1 是由创业公司 Genmo 开发并开源的最新文生视频模型,在动作质量和提示词的遵循能力方面展示了显著提升,但是原版模型需要4个H100GPU才能用,普通玩家根本玩不起,本期带来的是K大佬的量化模型,可以在24G及以内显卡使用,质量肯定是没有原版模型好,仅供尝试娱乐。

开源地址:https://github.com/kijai/ComfyUI-MochiWrapper

☞☞☞☞☞☞ 右侧下载整合包 ☞☞☞☞☞☞

视频教程:

配置要求:

电脑需满足以下配置:

- 操作系统:Windows 10/11 64位

- 显卡:FB16精度模型推荐显存24G英伟达(NVIDIA)显卡,FP8精度模型推荐显存16G英伟达(NVIDIA)显卡,16G显存以下英伟达(NVIDIA)显卡使用GGUF模型

- CUDA >= 12.4

- 整个包解压完约54.8G,要留足硬盘空间

电脑如未安装CUDA可以查看安装教程:https://aiyy.info/requirements/

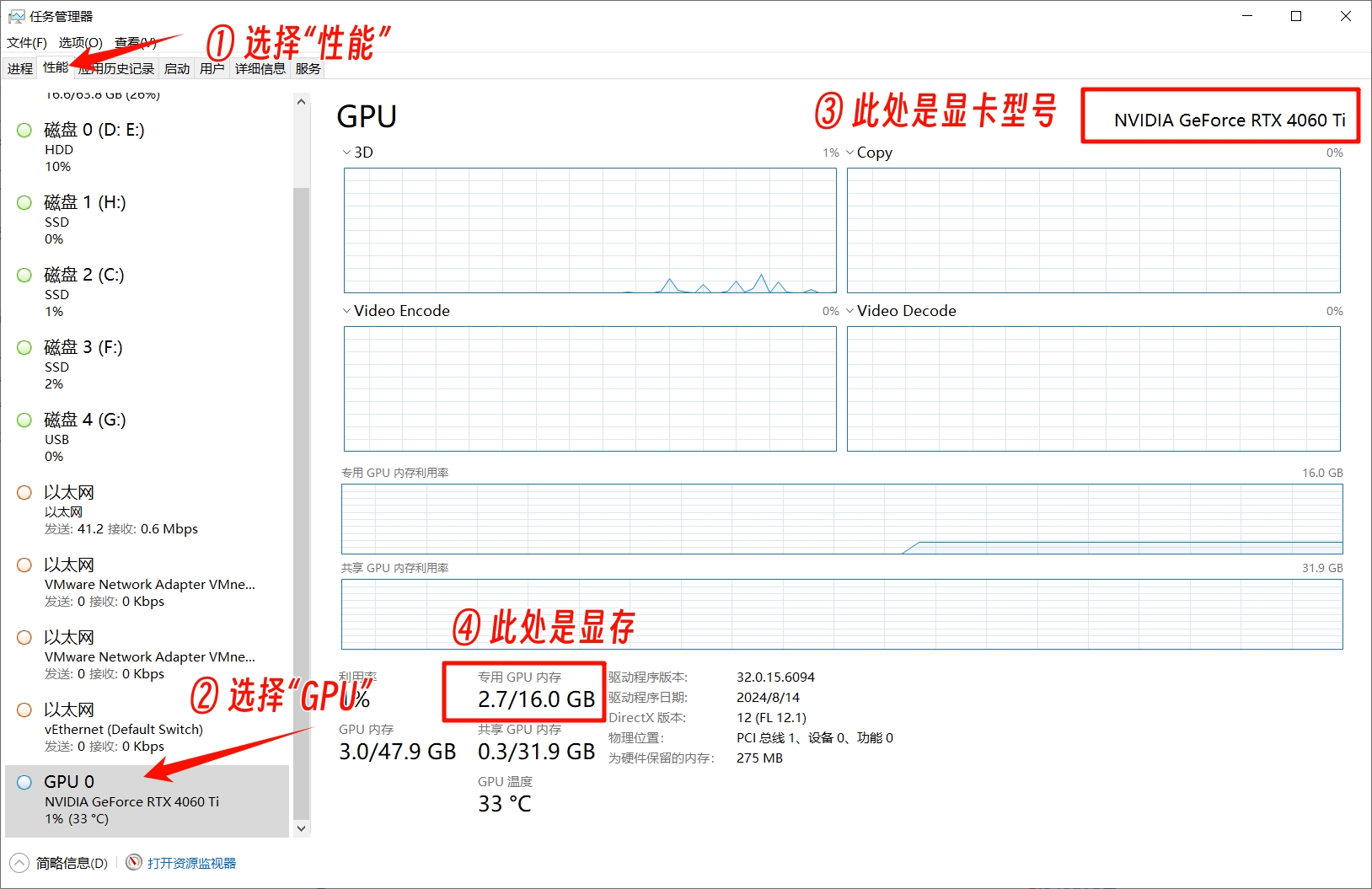

如何查看显卡品牌型号和显存:

- 打开任务管理器

- 点击“性能”

- 点击“GPU”

- 右上角可以看到显卡型号,下方可以看到显存大小

使用教程:

① 打开下载页面(https://aiyy.info/mochi/)点击页面右侧下载按钮,下载整合包之后解压,建议使用winrar解压(解压软件下载地址:https://www.winrar.com.cn/)

注意:文件夹路径和文件名称(包括音频、图片、视频等文件名称)不要出现中文字符,否则部分软件会因识别不出而报错

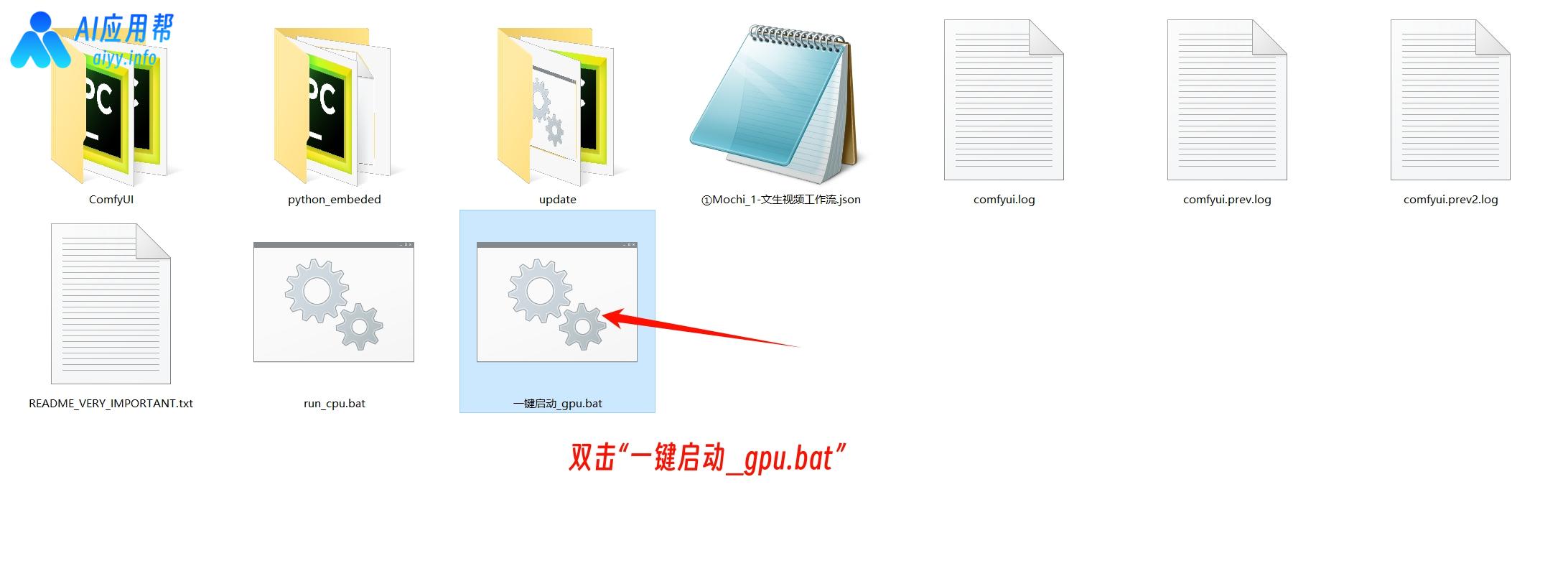

② 双击“一键启动_gpu.bat”,稍等片刻会在浏览器中自动打开操作界面

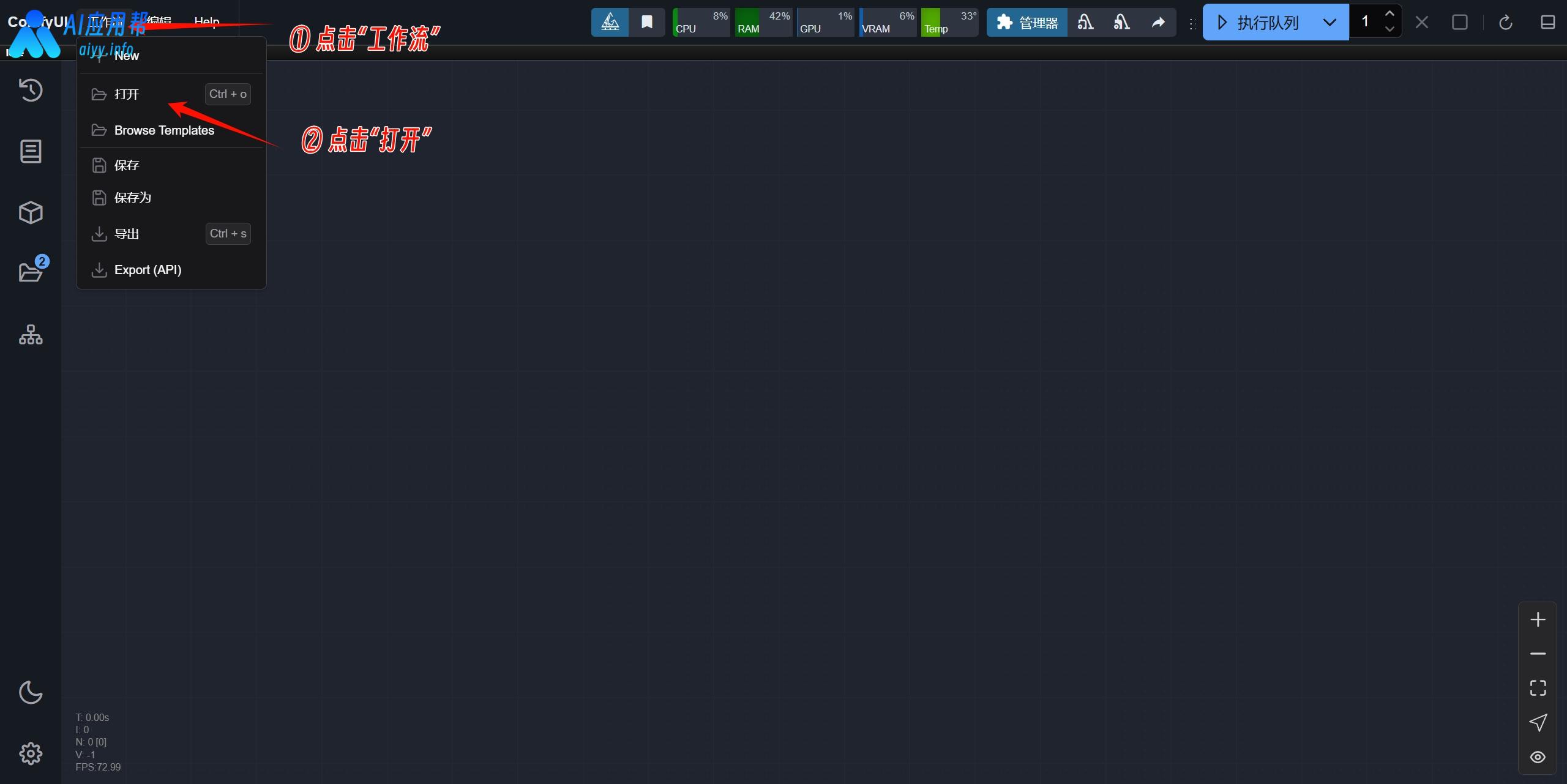

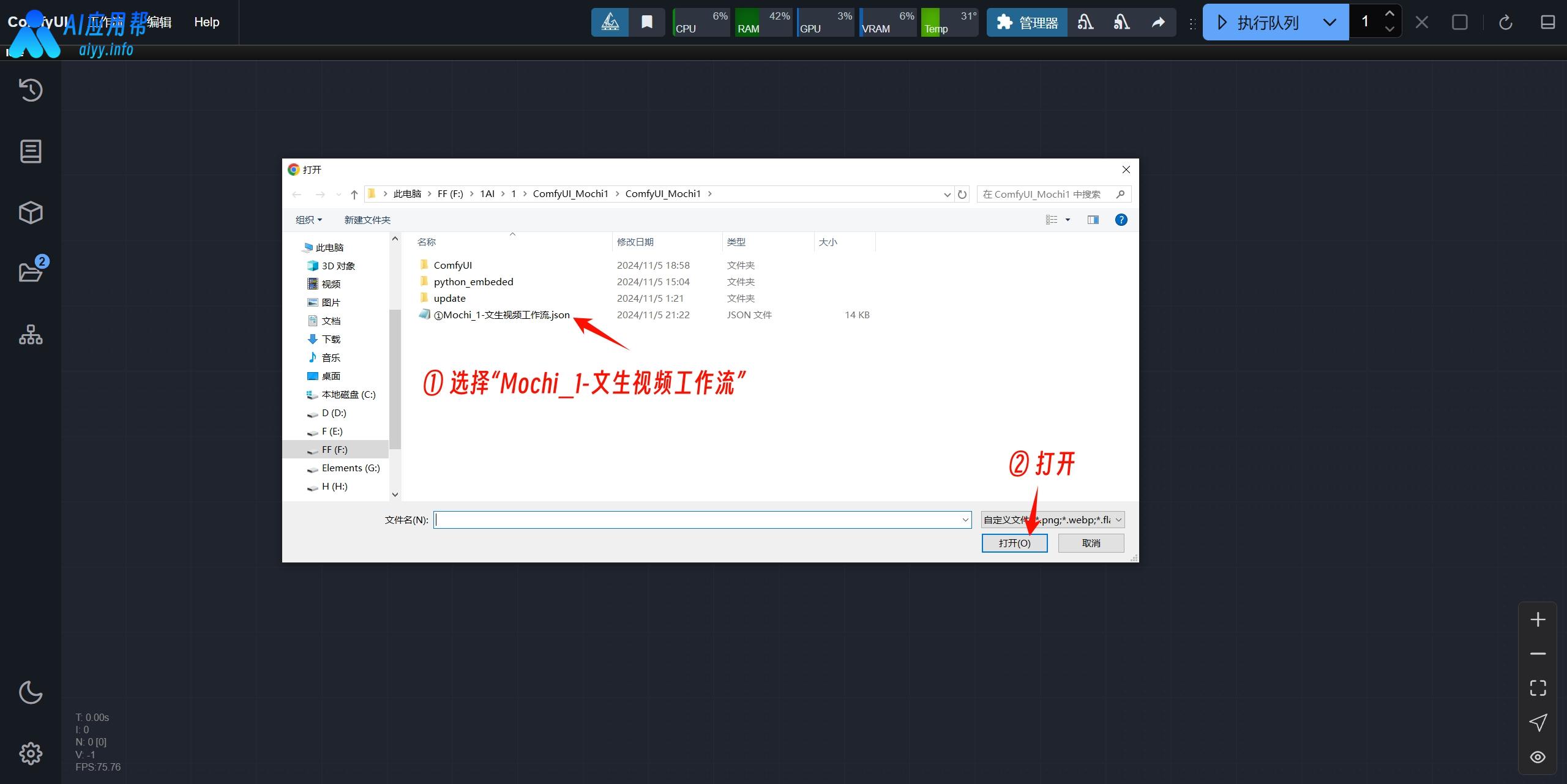

③ 点击左上角“工作流”,再点击“打开”

④ 选择“Mochi_1-文生视频工作流.json”工作流,打开

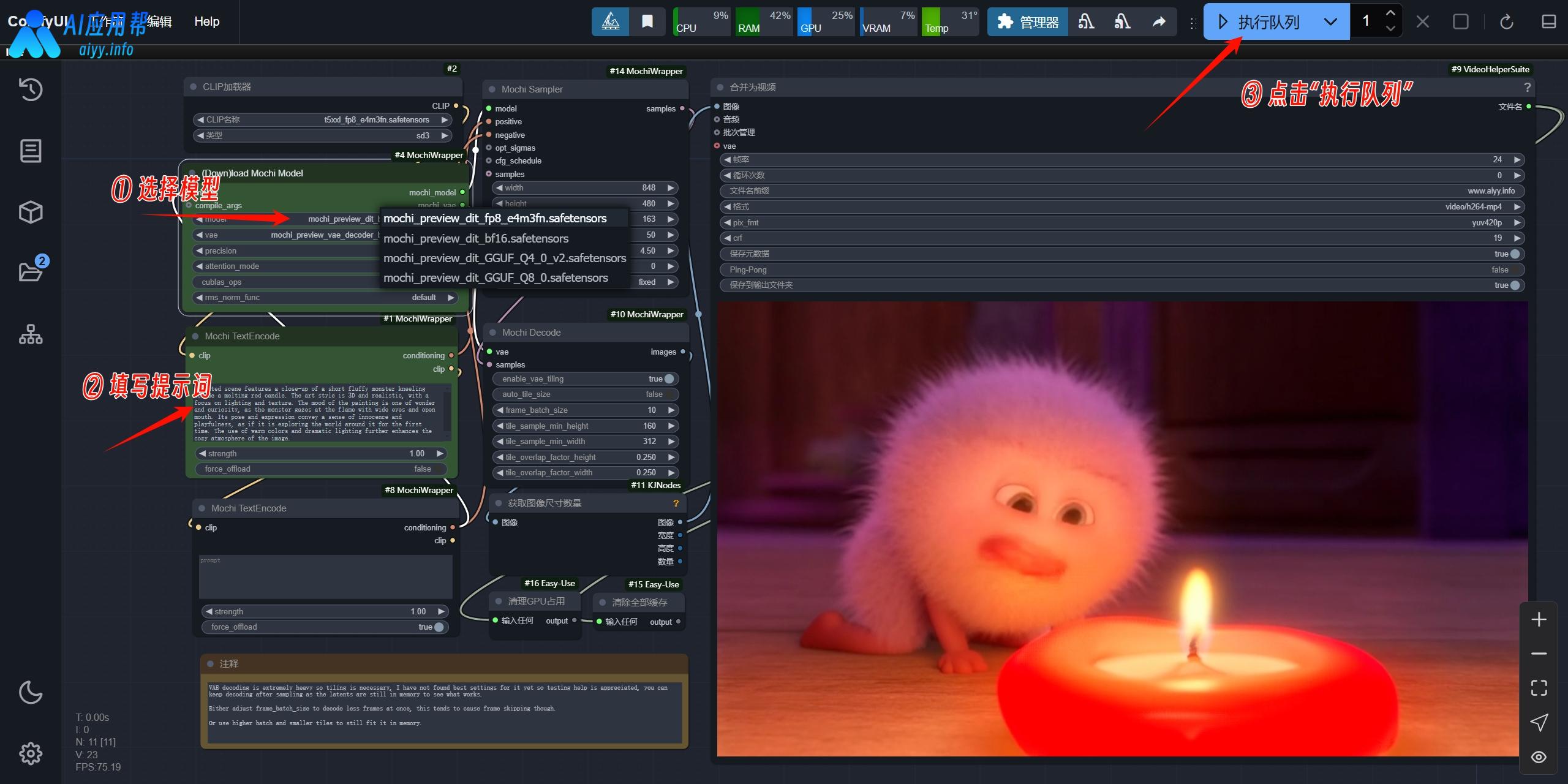

⑤ 选择模型(FB16精度模型推荐显存24G英伟达(NVIDIA)显卡,FP8精度模型推荐显存16G英伟达(NVIDIA)显卡,16G显存以下英伟达(NVIDIA)显卡使用GGUF模型),填写提示词,其他参数可以默认,然后点击“执行队列”

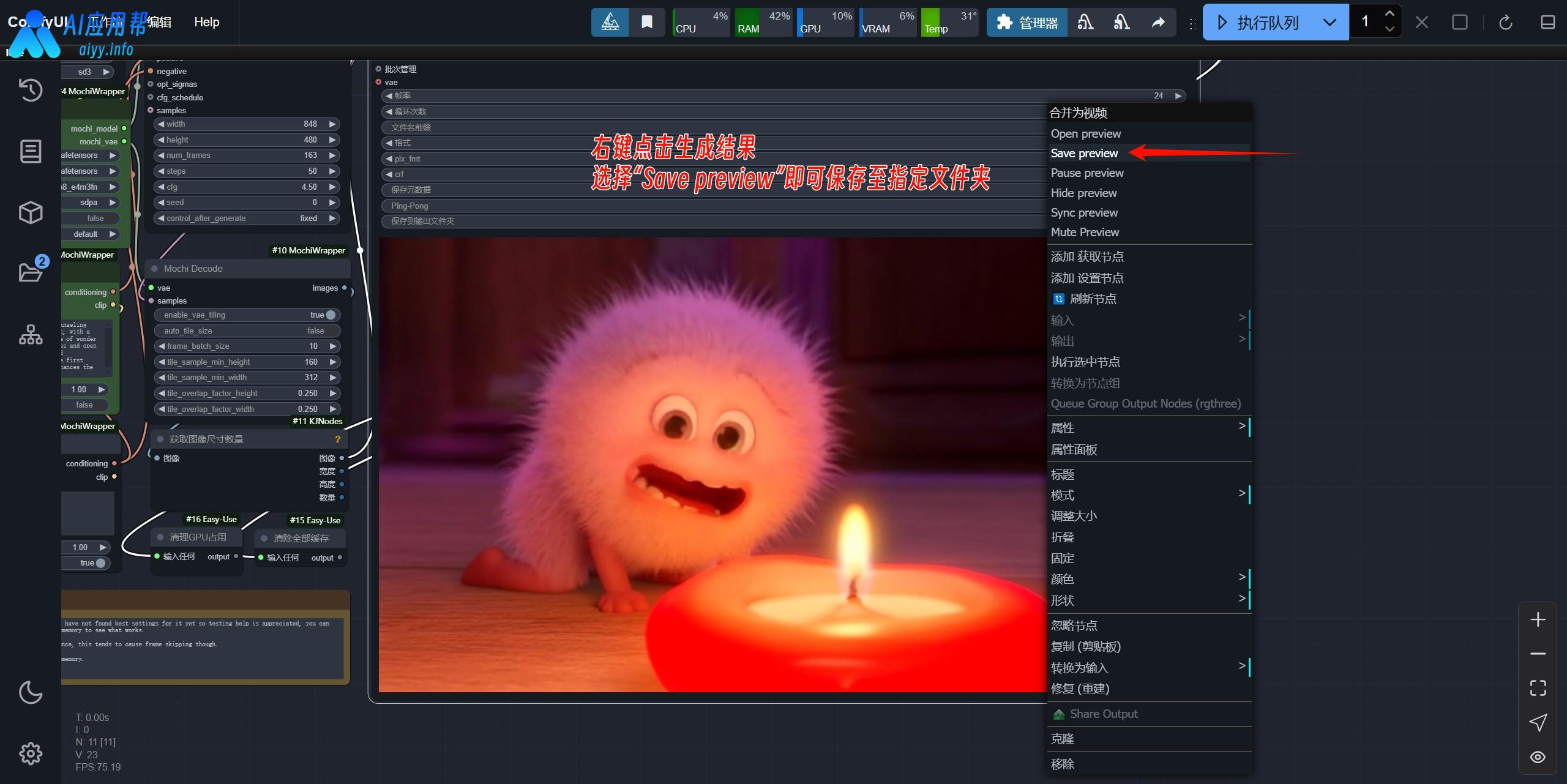

⑥ 右键点击生成结果,选择“save preview”即可保存至指定文件夹

或者在文件包中的“ComfyUI / output”目录下也能找到生成结果